2024-07-14 16:37:01

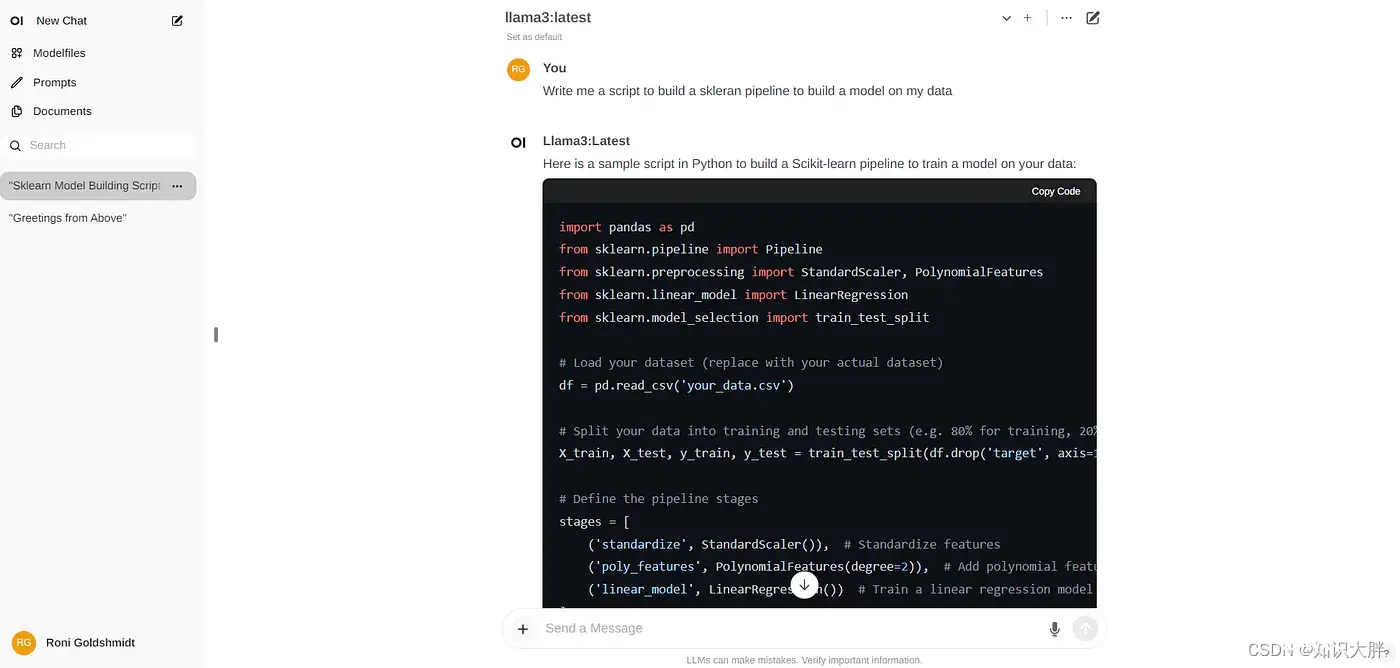

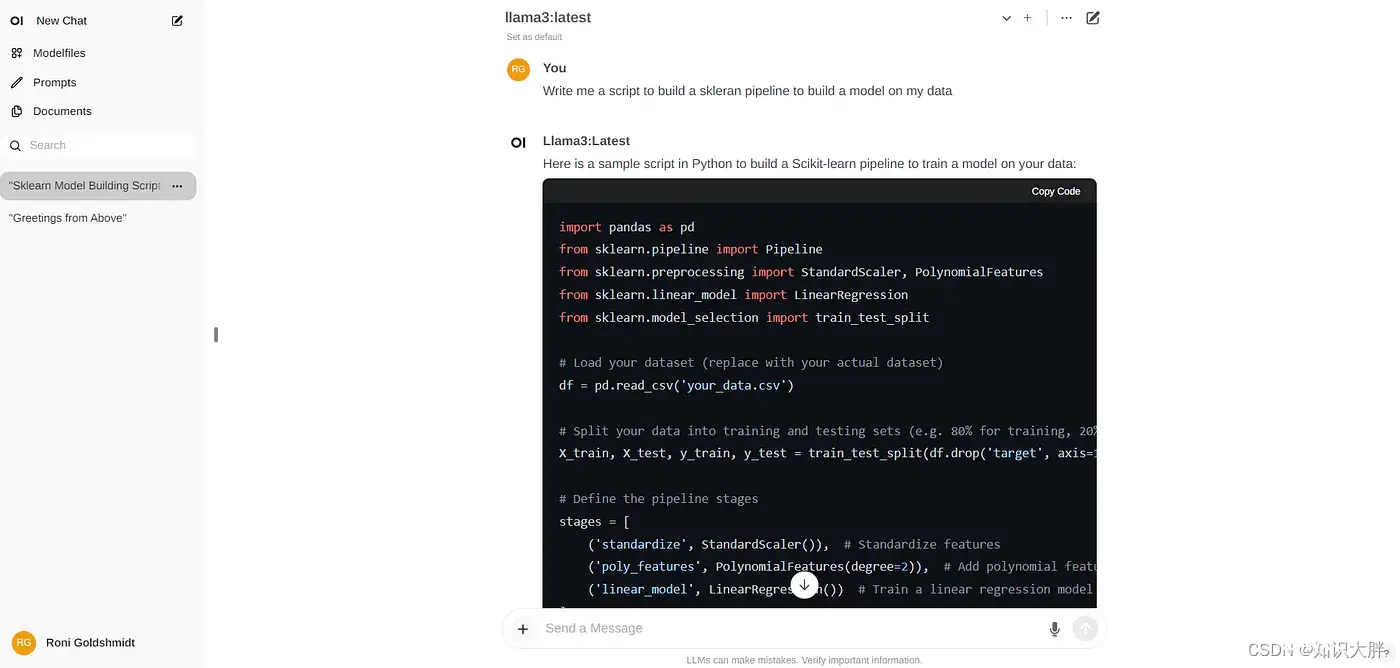

Ollama是一个强大的框架,专为大型语言模型的本地执行而设计。它提供了一种用户友好的方法来部署和管理人工智能模型,使用户能够直接从他们的机器运行各种预训练或自定义模型。Ollama的多功能性突出在于其全面的模型库,范围从较小的80...

Ollama是一个强大的框架,专为大型语言模型的本地执行而设计。它提供了一种用户友好的方法来部署和管理人工智能模型,使用户能够直接从他们的机器运行各种预训练或自定义模型。Ollama的多功能性突出在于其全面的模型库,范围从较小的80...